新版有道翻译通过深度整合与优化,成功利用现代智能手机内置的NPU(神经网络处理单元),将原本需要云端服务器运行的庞大神经网络翻译模型(NMT)高效部署在用户设备上,实现了接近在线翻译速度和质量的离线翻译体验。 这一技术突破,不仅解决了传统离线翻译速度慢、质量差的痛点,更在无网络环境下为用户提供了即时、可靠且高度注重隐私的翻译服务,标志着移动翻译正式迈入由“端侧算力”驱动的新纪元。有道将深入剖析其背后的技术原理、用户体验的飞跃以及对整个AI应用生态的深远影响。

文章目录

告别等待与网络束缚:离线翻译的新纪元

对于频繁出境的商旅人士、探险爱好者或是身处网络信号不佳环境的用户来说,离线翻译功能一直是手机翻译APP中不可或缺的一部分。然而,过去的体验却总伴随着些许无奈。如今,以有道翻译为代表的新一代翻译应用,正通过 harnessing a smartphone’s native power,彻底改写离线翻译的定义。

传统离线翻译的痛点:为何我们曾“又爱又恨”?

我们对传统离线翻译的感情是复杂的。一方面,它解决了“有无”的问题,让我们在没有网络时至少拥有了沟通的可能。但另一方面,其体验上的“痛点”也显而易见。首先是速度慢,翻译一段话往往需要数秒甚至更长的等待时间,在需要快速交流的场景下显得力不从心。其次是质量参差不齐,受限于设备性能和离线包大小,早期的离线翻译多采用基于统计的机器翻译(SMT)技术,其翻译结果生硬、不自然,远无法与在线的神经网络翻译(NMT)相媲美。最后是体积庞大,高质量的离线语言包动辄数百兆,给手机存储空间带来不小的压力。

新版有道翻译的革新:速度、质量与隐私的“三位一体”

新版有道翻译的出现,正是为了终结这些痛点。它所带来的革新,是围绕速度、质量、隐私这三个核心维度的全面升级。通过利用手机硬件中专门为AI运算设计的NPU,有道翻译实现了离线状态下的毫秒级响应,无论是文本输入、语音对话还是拍照翻译,其流畅度几乎可以媲美在线服务。更重要的是,它将有道自研的、业界领先的NMT模型成功“搬”到了手机上,这意味着离线翻译的质量也得到了质的飞跃,译文更加精准、流畅和人性化。同时,所有计算过程均在本地完成,数据不出手机,从根本上保障了用户的隐私安全。

核心解密:什么是NPU?它如何赋能有道翻译?

要理解有道翻译这次技术飞跃的关键,就必须先了解驱动这一切的硬件核心——NPU。这个看似陌生的缩写,正是近年来智能手机性能竞赛中的一个关键变量,也是实现高效“端侧AI”的基石。

NPU vs. CPU/GPU:手机中的“AI专属大脑”

在智能手机的芯片(SoC)中,通常包含多个处理单元,各司其职。CPU(中央处理器)是通用计算核心,擅长处理复杂的逻辑控制和串行任务,就像一个全能的管家。GPU(图形处理器)则为并行计算而生,能同时处理大量简单的数学运算,非常适合图像渲染,好比一个庞大的计算工厂。而NPU(神经网络处理单元),则是为AI计算量身定制的“专属大脑”。它专门优化了神经网络中常见的矩阵乘法、卷积等运算,能效比极高,可以用更低的功耗完成更快的AI推理任务。有道翻译正是巧妙地将翻译任务从“全能管家”或“计算工厂”手中,交给了这位“AI专家”来处理。

| 处理单元 | 核心特点 | 擅长任务 | 在翻译应用中的角色(传统 vs. 现代) |

|---|---|---|---|

| CPU | 逻辑控制强,通用性好 | 应用调度、系统管理 | 传统:处理所有离线翻译计算,速度慢,功耗高。 |

| GPU | 大规模并行计算 | 图形渲染、部分AI加速 | 部分应用:可用于加速,但能效不如NPU。 |

| NPU | AI运算能效比极高 | 神经网络推理、机器学习 | 有道翻译新版:专职处理NMT模型运算,实现高速、低功耗离线翻译。 |

有道自研NMT模型与NPU的“天作之合”

硬件的升级只是前提,真正的壁垒在于软硬件的协同优化。作为国内最早投入神经网络翻译研究的公司之一,有道拥有深厚的技术积累和完全自主研发的NMT模型。这使得有道翻译团队能够从模型底层架构出发,针对主流手机芯片厂商(如高通、联发科、麒麟等)的NPU特性进行深度适配和优化。这种“从上到下”的垂直整合能力,确保了翻译模型能够在不同的NPU平台上发挥出最大效能,实现了算法与硬件的“天作之合”,这是许多依赖第三方通用模型的应用所不具备的优势,也是其卓越性能表现的根本原因。

模型量化与优化:将“庞大”的AI模型装进手机

云端的NMT模型通常参数量巨大,结构复杂,直接移植到手机上是不可行的。这里的核心技术挑战在于模型压缩。有道的技术团队采用了包括模型量化(Quantization)、剪枝(Pruning)、知识蒸馏(Knowledge Distillation)在内的一系列先进技术。模型量化好比将高精度的浮点数运算(如FP32)转换为低精度的整数运算(如INT8),在略微牺牲极小部分精度的情况下,大幅减小模型体积和计算量,使其更适合在NPU上高效运行。通过这些“瘦身”手术,有道成功地将原本庞大的AI模型压缩到可以轻松装入手机离线包的大小,同时最大限度地保留了其翻译质量。

用户体验的飞跃:新版有道离线翻译实测与优势分析

技术最终要服务于人。对于用户而言,最直观的感受就是体验上的巨大提升。新版有道离线翻译在多个核心场景下,都展现出了颠覆性的优势。

极速响应:即拍即译,对话无延迟

过去使用离线拍照翻译,从对准菜单、拍照到最终显示翻译结果,整个过程可能需要5-10秒。而现在,得益于NPU的加持,新版有道翻译的离线拍照功能几乎做到了“即拍即译”。当摄像头对准外文时,屏幕上的翻译结果能够实时刷新,体验无限接近AR翻译。在跨语言对话场景中,延迟的消除也让交流变得更加自然顺畅,不再有因等待翻译而产生的尴尬停顿,真正实现了无障碍沟通。

隐私安全:您的数据,只属于您

在线翻译虽然强大,但用户的语音、图片和文本数据都需要上传到云端服务器进行处理,这在处理涉及商业机密、个人隐私等敏感信息时,总会带来一丝顾虑。端侧AI的离线翻译模式从根本上解决了这个问题。因为所有的计算都在用户的手机本地进行,数据从始至终没有离开过设备。这种“物理隔绝”的方式,为用户提供了最高级别的隐私保障,让每一次翻译都安心无虞。

无网无忧:飞行模式、偏远地区的全场景覆盖

新版有道离线翻译的真正价值,在极限场景下被放大到极致。想象一下,在万米高空的国际航班上,你需要与邻座的外国友人交流,或看懂外文电影的菜单;或者你身处信号微弱的异国小镇、偏远山区,急需翻译路牌或与当地人沟通。在这些场景下,网络连接成为奢侈品,而一个性能强大、稳定可靠的离线翻译工具就如同救星。有道翻译提供的正是这种全天候、全场景的覆盖能力,确保你在任何情况下都能跨越语言障碍。

超越翻译:端侧AI开启的无限可能

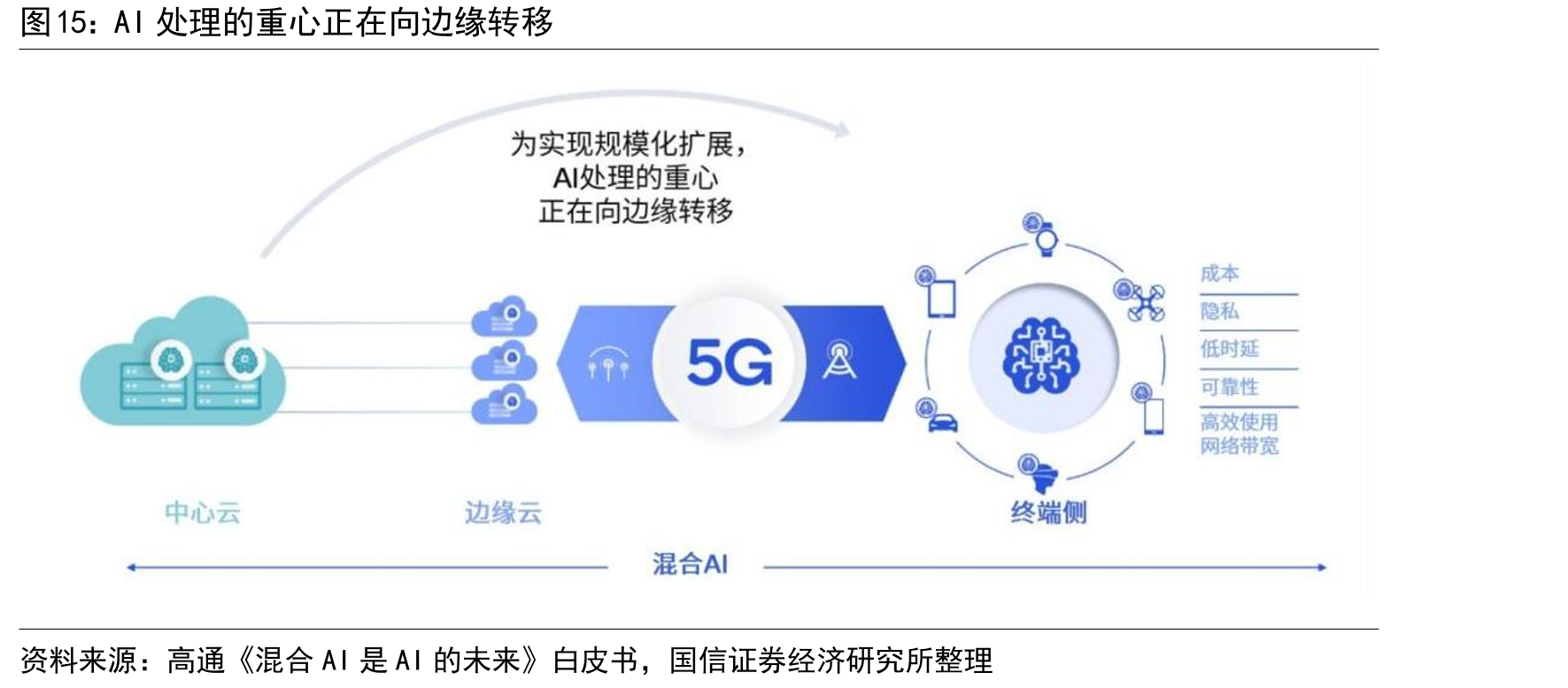

有道翻译在离线场景的突破,不仅仅是一个应用的成功,更是一个重要的行业风向标。它清晰地揭示了“端侧算力”正在为AI应用的形态和未来带来深刻的变革。

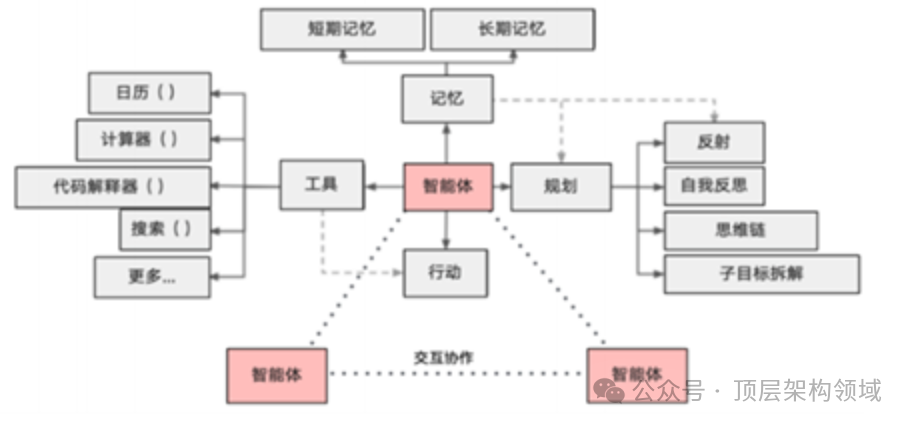

从有道翻译看端侧AI的未来趋势

随着手机NPU算力的持续指数级增长,以及AI模型优化技术的不断成熟,将有越来越多的复杂AI应用从云端走向端侧,或采用“云+端”协同的混合模式。未来的趋势将是:更即时的响应(如AI视觉特效、实时语音助手)、更强的隐私保护(如设备端的健康监测、行为分析)、更个性化的体验(如基于本地使用习惯的智能推荐)以及更低的运行成本(减少对云服务器的依赖)。有道翻译的实践,为其他领域的AI应用,如图像处理、智能语音、AR等,提供了一个绝佳的范本。

这对普通用户和行业意味着什么?

对于普通用户来说,这意味着我们手机上的App将变得更智能、更快速、更安全。我们不再需要为每一个智能功能都依赖稳定的网络连接,手机本身就将成为一个强大的、独立的AI处理中心。对于整个行业而言,端侧AI的兴起正在催生新的商业模式和竞争格局。能够掌握核心AI算法并具备软硬件协同优化能力的公司,如有道,将在未来的竞争中占据更有利的位置。这也将激励芯片制造商、手机厂商和应用开发者之间进行更紧密的合作,共同推动整个端侧AI生态的繁荣。

常见问题解答 (FAQ)

问:我的手机支持这项功能吗?

答:目前,新版有道翻译的NPU加速功能主要支持近年来发布的中高端智能手机,这些手机的SoC(芯片)大多内置了性能较强的NPU。您可以在有道翻译APP的离线包下载页面查看您的设备是否支持“NPU加速模式”,或留意应用更新说明。

问:新版离线翻译的语言包会很大吗?

答:得益于先进的模型压缩技术,尽管搭载了强大的NMT模型,新版有道翻译的离线语言包体积依然控制在了一个非常合理的范围内,与传统离线包相比没有显著增加,用户可以放心下载使用。

问:离线翻译的准确度和在线翻译还有差距吗?

答:虽然端侧模型的翻译质量已获得巨大提升,但在处理极其复杂、生僻或需要实时网络知识(如最新流行语)的句子时,拥有海量数据和更庞大模型的在线翻译仍然略有优势。不过,对于日常交流、旅游、商务等绝大多数场景,新版离线翻译的质量已经完全能够满足需求,差距已微乎其微。