摘要: 有道翻译官网将系统性地拆解并构建一个针对有道翻译的数据采集与处理解决方案。我们不仅会深入逆向分析其核心的JS加密反爬机制,还会从项目战略、架构设计、规模化采集、数据持久化处理,直至系统部署运维,提供一个完整、健壮、可扩展的实战指南。有道翻译官网旨在帮助开发者超越简单的“脚本小子”思维,建立起一套解决复杂数据采集需求的“工程师”方法论。

第一章:战略规划与可行性分析 (Strategic Planning & Feasibility)

在编写任何代码之前,专业的项目规划是成功的基石。本章将明确我们的目标,并评估技术与合规性风险。

-

1.1 项目目标与应用场景

内容: 明确构建此爬虫的核心目的。是为了进行学术研究(如多语言语料库构建)、商业分析(如竞品本地化文案研究),还是为了集成到内部应用中提供便捷的翻译功能?清晰的目标将指导后续的技术选型和架构设计。例如,一次性的大批量采集与持续性的低频采集在架构上会有显著差异。

-

1.2 技术可行性评估:直面反爬挑战

内容: 深入分析有道翻译的主要反爬手段。重点是其动态生成的加密参数(如

salt,内容: 探讨网络爬虫的灰色地带。分析有道翻译的`robots.txt`协议和用户服务条款。强调数据采集应遵循“最小化”和“合理使用”原则,避免对目标服务器造成过大压力。最重要的是,明确指出使用官方提供的API是更合规、更稳定的首选方案,并简要介绍其优缺点,将自建爬虫定位为在特定场景下的补充或替代方案。

第二章:核心技术解密:有道翻译反爬机制逆向工程

这是整个项目的技术核心。我们将像侦探一样,一步步揭开有道翻译加密参数的神秘面纱。

-

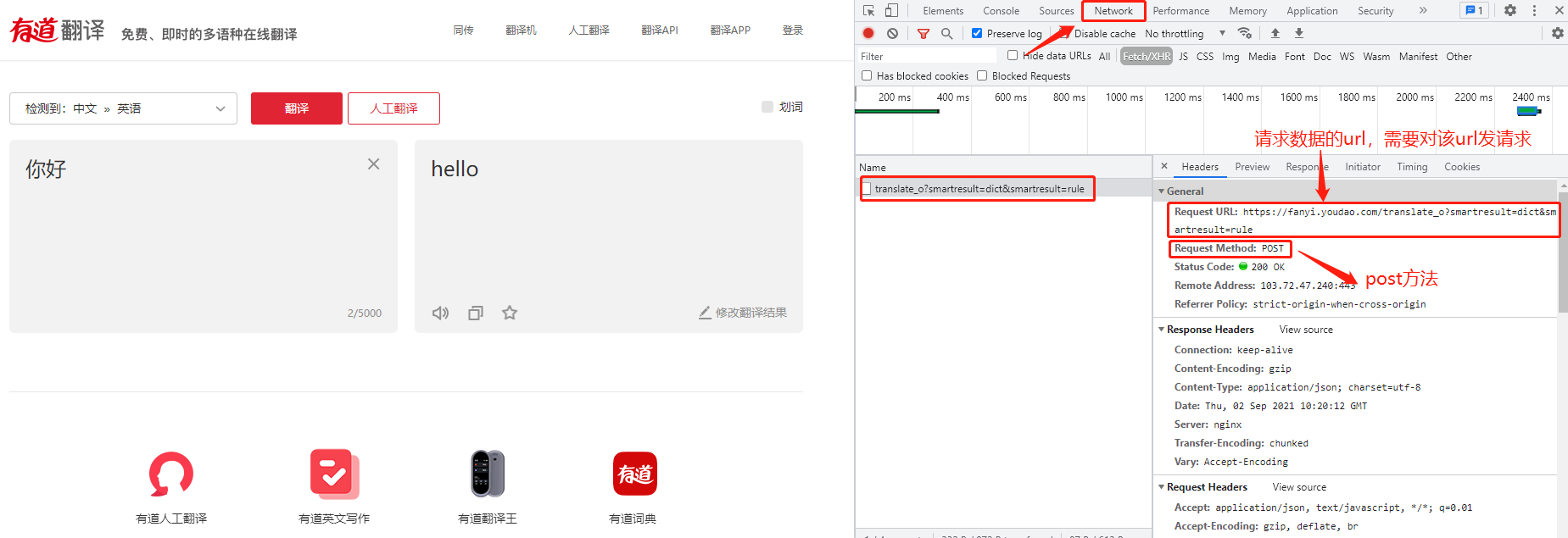

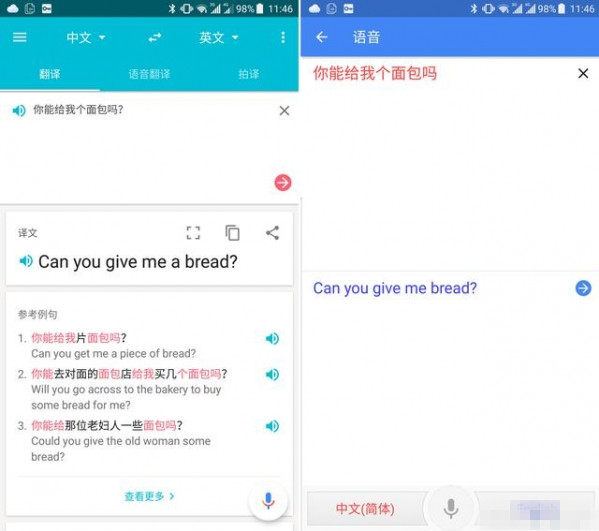

2.1 定位关键API与请求参数

内容: 使用Chrome开发者工具的“Network”面板,筛选XHR请求,精确定位到执行翻译功能的API接口(通常是 `…/translate_o?…`)。详细列出该请求的Headers、Request Method (POST)以及最重要的Form Data,逐一识别哪些参数是固定的,哪些是动态变化的。

-

2.2 JS逆向:追踪加密参数生成逻辑

内容: 本节是技术难点。通过在开发者工具的“Sources”面板中设置XHR断点或关键词(如 `sign`)搜索,定位到生成加密参数的核心JS代码。详细演示如何分析混淆和压缩过的JavaScript代码,识别出 `salt`(时间戳+随机数)、`sign`(基于待翻译文本、salt等通过特定算法(如MD5)生成的签名)等关键参数的完整生成过程。会附上关键JS代码片段并逐行注释其逻辑。

-

2.3 算法复现:从JavaScript到Python

内容: 将上一步分析出的JavaScript加密逻辑,用Python代码进行等价实现。这通常会涉及到使用`hashlib`库来计算MD5,`time`库来生成时间戳`lts`和`salt`。最终目标是编写一个Python函数,输入待翻译的文本,即可输出一个包含所有必需参数(`i`,有了核心技术,我们需要构建一个稳定、可维护的爬虫程序框架。

-

3.1 技术栈选择

内容: 阐述为何选择 Python 作为主要开发语言,并确定核心库组合:`requests` (用于发送HTTP请求)、`json` (用于解析响应)。对于更复杂的场景,可以讨论引入`Scrapy`框架的利弊。

-

3.2 模块化代码结构

内容: 设计清晰的代码结构。例如,创建一个`youdao_translator.py`文件,内部包含:

ParamGenerator类:封装所有加密参数的生成逻辑。Translator类:负责发起网络请求、处理响应。其`translate()`方法接收文本,调用`ParamGenerator`,发送请求,并返回解析后的翻译结果。- `main.py`:作为主入口,负责读取待翻译的词条列表,调用`Translator`并处理最终结果。

-

3.3 健壮性设计:错误处理与日志记录

内容: 编写能够应对现实世界问题的代码。使用`try…except`块捕获网络异常(如`requests.exceptions.RequestException`)、JSON解析错误、API返回的错误码(如请求频繁被拒)。引入`logging`模块,将关键操作、成功信息和错误详情记录到文件中,便于调试和问题追溯。

第四章:高可用与规模化采集策略

当需要翻译成千上万个词条时,单个IP和同步请求将很快达到瓶颈。本章聚焦于如何将爬虫扩展到“生产级”。

-

4.1 IP代理池的应用

内容: 解释为什么需要代理IP(防止因请求频率过高而被封禁)。介绍代理IP的类型(透明、匿名、高匿)和获取方式(付费服务、自建代理池)。演示如何在`requests`请求中配置和使用代理,并设计策略来自动切换失效的代理。

-

4.2 伪装与反侦察

内容: 除了IP,还需伪装其他特征。重点是动态维护一个`User-Agent`列表,并在每次请求时随机选择一个。讨论其他可能被检测的Headers(如`Referer`,内容: 分析同步阻塞模型的效率瓶颈。介绍并对比两种主流的性能提升方案:

- 多线程/多进程: 使用`threading`或`multiprocessing`库,并行处理多个翻译任务。适合IO密集型任务。

- 异步IO: 使用`asyncio` + `aiohttp`,在单线程内实现高并发。代码逻辑更复杂,但资源消耗更低,性能上限更高。提供简化的代码范例。

-

4.4 智能限速与重试机制

内容: 设计一个礼貌而高效的请求策略。实现一个动态的请求延迟机制(例如,在每次请求后随机`sleep(1,采集到的数据是原始的,需要清洗和妥善存储才能发挥价值。

-

5.1 数据清洗与规范化

内容: 从API返回的JSON中提取所需字段(原文、译文、发音等)。对数据进行清洗,例如去除不必要的HTML标签、统一文本编码为UTF-8、处理空值或异常值。设计一个标准化的数据结构(如Python字典或自定义对象)来承载每一条翻译记录。

-

5.2 存储方案选型与设计

内容: 根据项目需求对比不同的数据存储方案:

- CSV/JSON文件: 简单快捷,适合小批量、一次性任务。

- SQLite: 轻量级数据库,无需单独的服务进程,适合中小型项目和本地应用。

- MySQL/PostgreSQL: 强大的关系型数据库,支持复杂的查询和事务,适合大规模、高可靠性的企业级应用。

- MongoDB/Redis: NoSQL数据库。MongoDB的文档模型与JSON天然契合;Redis可用于构建高速缓存或任务队列。

本节将以SQLite和MySQL为例,提供创建数据表(包含字段:`id`,一个完整的解决方案需要能够脱离开发环境,在服务器上稳定、自动地运行。

-

6.1 部署方案

内容: 介绍如何将爬虫项目部署到Linux服务器。包括创建虚拟环境、安装依赖。重点推荐使用**Docker**进行容器化部署,提供一个简单的`Dockerfile`示例,以实现环境隔离和一键部署。

-

6.2 任务调度与自动化

内容: 对于需要定期运行的采集任务,介绍如何使用Linux的`crontab`来设置定时执行。对于更复杂的调度需求(如任务依赖、分布式执行),可以简要提及`Celery`等专业任务队列框架。

-

6.3 监控与告警

内容: 强调监控的重要性。可以通过日志分析工具(如`ELK Stack`)来监控爬虫运行状态。设置基本告警机制,例如,当连续出现大量错误时,通过邮件或企业微信/Slack机器人发送通知,以便及时介入处理。这标志着项目从一个“脚本”真正演变为一个“服务”。

总结与展望

内容: 回顾整个流程,从战略规划到运维监控,我们构建了一个完整的、工业级的有道翻译数据解决方案。再次强调,技术的价值在于解决问题,而一个优秀的工程师不仅要掌握“如何实现”的技巧,更要具备“为何构建”的视野和“如何持续”的思维。最后,提醒读者网站反爬策略会不断更新,逆向分析和代码维护将是一个持续的过程。

-

-